مساحة الحدث عشوائية

في عام 1946، اقترح الإحصائي الأمريكي جون توكي اسم BIT

تخيل مساحة من الأحداث العشوائيةالذي يتكون من رمي عملة واحدة مزيفة ، على جانبيها هو النسر. متى يسقط النسر؟ من الواضح أن دائما. نحن نعلم ذلك مقدمًا ، لأن مساحتنا مرتبة جدًا. يعد سقوط النسر حدثًا موثوقًا به ، أي أن احتماله يساوي 1. هل سنقدم الكثير من المعلومات إذا قلنا عن نسر ما؟ لا. مقدار المعلومات في مثل هذه الرسالة ، سوف نعتبر مساويا للصفر.

الآن دعونا نقلب العملة العادلة:من جهة رؤوس، ومن جهة أخرى ذيول، كما ينبغي أن يكون. ستكون الرؤوس أو الذيول الهبوطية حدثين مختلفين يشكلان مساحة الأحداث العشوائية لدينا. إذا أبلغنا عن نتيجة رمية واحدة، فستكون بالفعل معلومات جديدة. إذا تم إسقاط الصورة، فسوف نبلغ 0، وإذا كانت الكتابة 1. ومن أجل الإبلاغ عن هذه المعلومات، نحتاج فقط إلى بت واحد.

ما الذي تغير؟لقد ظهر عدم اليقين في مساحة الحدث لدينا. لدينا ما نقوله عن ذلك لشخص لا يرمي عملة معدنية بنفسه ولا يرى نتيجة القرعة. ولكن لكي يفهم رسالتنا بشكل صحيح، يجب عليه أن يعرف بالضبط ما نقوم به وما يعنيه الصفر والواحد.يجب أن تتطابق مساحات الأحداث الخاصة بنا ، وتكون عملية فك الترميز فريدة لاستعادة نتيجة الرمي.إذا لم تتطابق مساحة الحدث للمرسل والمستقبل أو لم يكن هناك إمكانية لفك تشفير الرسالة بشكل لا لبس فيه، فستبقى المعلومات مجرد ضجيج في قناة الاتصال.

إذا قمت برمي اثنين بشكل مستقل وفي وقت واحدعملات معدنية، فسيكون هناك أربع نتائج مختلفة ومتساوية الاحتمال: رؤوس رؤوس، رؤوس ذيول، رؤوس ذيول، رؤوس ذيول. لنقل المعلومات، سنحتاج إلى 2 بت، وستكون رسائلنا على النحو التالي: 00 و01 و10 و11. هناك ضعف كمية المعلومات. حدث هذا بسبب زيادة عدم اليقين. إذا حاولنا تخمين نتيجة مثل هذه الرمية المزدوجة، فلدينا فرصة مضاعفة للخطأ.

كلما زاد عدم اليقين في مساحة الحدث، زادت المعلومات التي تحتويها الرسالة حول حالتها.

دعونا تعقيد مساحة الحدث لدينا قليلا.حتى الآن، كل الأحداث التي حدثت كانت محتملة بنفس القدر. لكن في الفضاء الحقيقي، ليست كل الأحداث لها احتمالات متساوية. لنفترض أن احتمال أن يكون الغراب الذي نراه أسود اللون يقترب من 1. واحتمال أن يكون أول عابر سبيل نلتقي به في الشارع رجلاً هو 0.5 تقريبًا. لكن لقاء التمساح في شوارع موسكو يكاد يكون مستحيلاً. بشكل حدسي، نحن ندرك أن التقرير عن لقاء مع تمساح له قيمة معلوماتية أكبر بكثير من التقرير عن الغراب الأسود.كلما انخفض احتمال وقوع حدث ، زادت المعلومات الموجودة في الرسالة حول هذا الحدث.

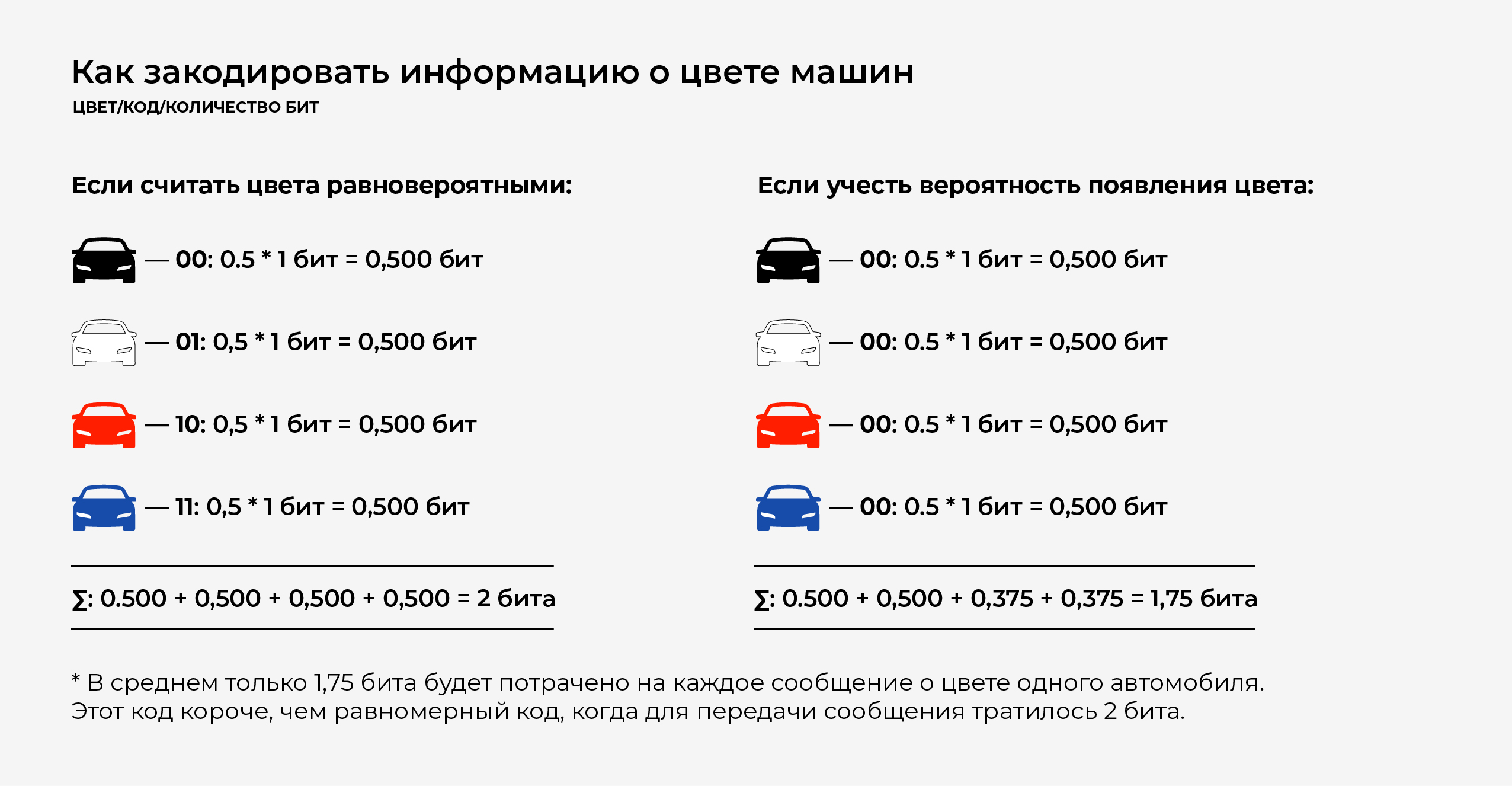

دع مساحة الحدث لا تكون غريبة للغاية. نحن فقط نقف عند النافذة وننظر إلى السيارات المارة. سيارات من أربعة ألوان تمر ، والتي نحتاج إلى الإبلاغ عنها. للقيام بذلك ، سنقوم بتشفير الألوان: الأسود - 00 ، والأبيض - 01 ، والأحمر - 10 ، والأزرق - 11. للإبلاغ بدقة عن السيارة التي تقودها ، نحتاج فقط إلى نقل 2 بت من المعلومات.

ولكن لفترة طويلة مشاهدة السيارات ،نلاحظ أن لون السيارات موزعة بشكل غير متساو: أسود - 50 ٪ (كل ثانية) ، أبيض - 25 ٪ (كل ربع) ، أحمر وأزرق - 12.5 ٪ (كل الثامنة). ثم يمكنك تحسين المعلومات المرسلة.

معظم السيارات سوداء اللون، لذلكدعنا نشير إلى اللون الأسود - 0 - أقصر رمز، ودع رمز الباقي يبدأ عند 1. من النصف المتبقي، الأبيض - 10، والألوان المتبقية تبدأ عند 11. أخيرًا، دعنا نشير إلى اللون الأحمر - 110، والأزرق - 111.

الآن ، بتمرير معلومات حول لون السيارة ، يمكننا تشفيرها عن كثب.

شانون انتروبي

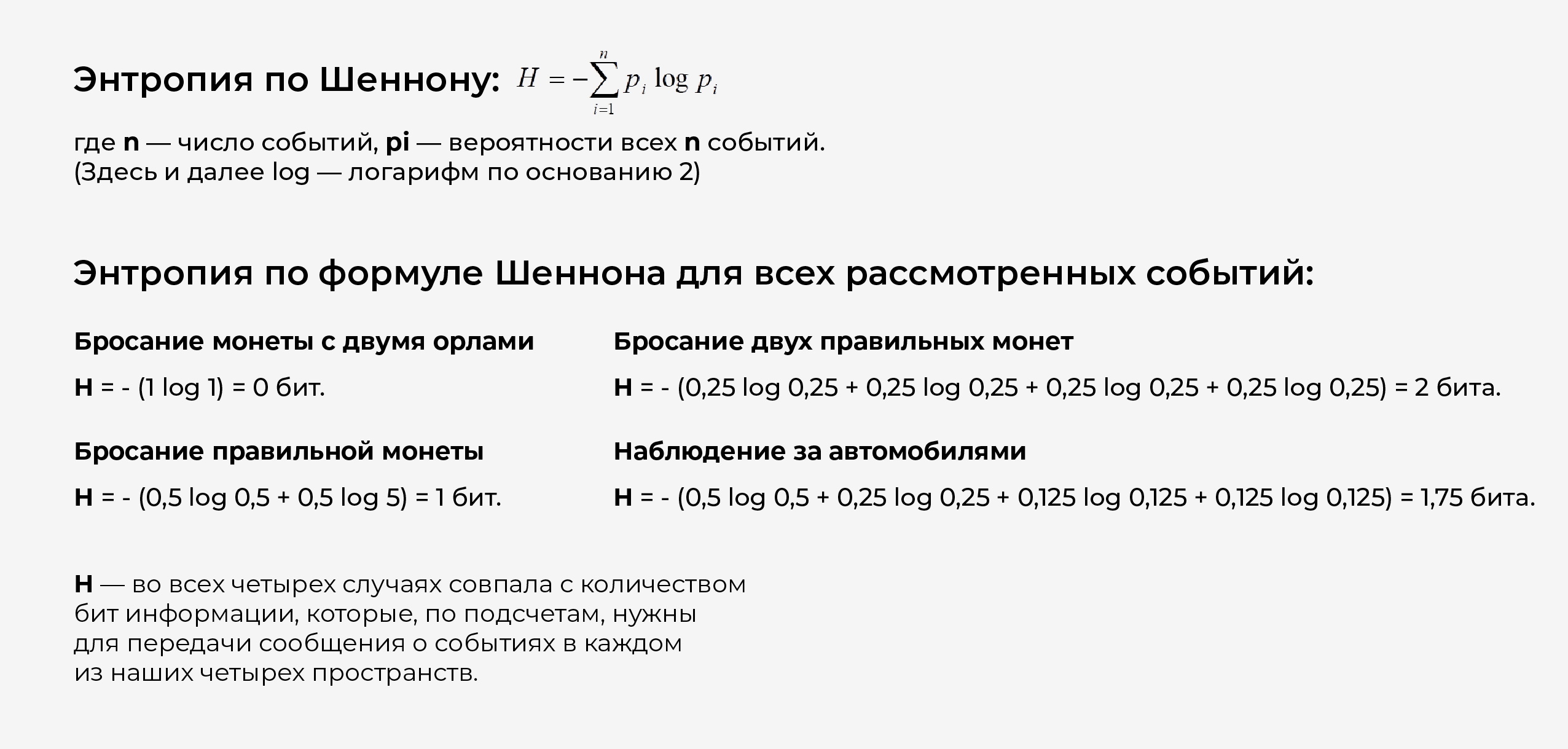

دع مساحة الحدث لدينا تتكون من nأحداث مختلفة. عند رمي عملة معدنية برأسين، يكون هناك حدث واحد بالضبط من هذا القبيل، وعندما يتم رمي عملة معدنية واحدة يكون هناك بالضبط 2، وعند رمي عملتين أو مشاهدة السيارات يكون هناك 4 بالضبط. كل حدث لديه احتمال حدوثه. عند رمي عملة ذات وجهين، هناك حدث واحد (رؤوس تسقط) واحتماله هو p1 = 1. عند رمي عملة معدنية، هناك حدثان، متساويان في الاحتمال واحتمال كل منهما هو 0.5: p1 = 0.5، p2 = 0.5. عند رمي عملتين عاديتين، هناك أربعة أحداث، جميعها متساوية في الاحتمال واحتمال كل منها هو 0.25: p1 = 0.25، p2 = 0.25، p3 = 0.25، p4 = 0.25. عند مراقبة السيارات، هناك أربعة أحداث، ولها احتمالات مختلفة: أسود - 0.5، أبيض - 0.25، أحمر - 0.125، أزرق - 0.125: p1 = 0.5، p2 = 0.25، p3 = 0.125، p4 = 0.125.

هذا ليس مصادفة.اختار شانون الانتروبيا (مقياس من عدم اليقين في مساحة الحدث) بحيث تم استيفاء ثلاثة شروط:

- 1إنتروبيا حدث موثوق، احتماله 1، يساوي 0.

- إن إنتروبيا حدثين مستقلين يساوي مجموع إنتروبيا هذه الأحداث.

- الانتروبيا هو الحد الأقصى إذا كانت جميع الأحداث محتملة على قدم المساواة.

كل هذه المتطلبات تتفق تماما مع لديناأفكار حول عدم اليقين في مساحة الحدث. إذا كان هناك حدث واحد فقط (المثال الأول)، فلا يوجد شك. إذا كانت الأحداث مستقلة - عدم اليقين في المجموع يساوي مجموع حالات عدم اليقين - فهي ببساطة تضيف ما يصل (مثال رمي عملتين معدنيتين). وأخيرًا، إذا كانت جميع الأحداث متساوية في الاحتمال، فإن درجة عدم اليقين في النظام تكون الحد الأقصى. كما في حالة رمي عملتين، فإن الأحداث الأربعة جميعها متساوية في الاحتمال والإنتروبيا 2، وهي أكبر مما هي عليه في حالة السيارات، عندما يكون هناك أيضًا أربعة أحداث، لكن لها احتمالات مختلفة - في هذه الحالة الإنتروبيا هي 1.75.

تلعب الكمية H دورًا مركزيًا في نظرية المعلومات كمقياس للمعلومات والاختيار وعدم اليقين.

كلود شانون

كلود إلوود شانون- مهندس ومحلل تشفير أمريكيرياضياتي. يعتبر "أبو عصر المعلومات". مؤسس نظرية المعلومات، والتي وجدت التطبيق في أنظمة الاتصالات الحديثة ذات التقنية العالية. قدم المفاهيم والأفكار الأساسية وصياغاتها الرياضية التي تشكل حاليًا الأساس لتقنيات الاتصال الحديثة.

في عام 1948 ، اقترح استخدام كلمة "bit"للإشارة إلى أصغر وحدة معلومات. كما أظهر أن الانتروبيا التي أدخلها تعادل عدم اليقين في المعلومات الواردة في الرسالة المرسلة. تعتبر مقالات شانون "النظرية الرياضية للاتصال" و "نظرية الاتصال في الأنظمة السرية" أساسية لنظرية المعلومات والتشفير.

خلال الحرب العالمية الثانية، عمل شانون في مختبرات بيل لتطوير أنظمة التشفير، مما ساعده لاحقًا على اكتشاف طرق تشفير تصحيح الأخطاء.

ساهم شانون مساهمة أساسية في نظرية المخططات الاحتمالية ، نظرية الألعاب ، نظرية الأوتوماتة ونظرية نظام التحكم - مجالات العلوم التي تشكل جزءًا من مفهوم علم التحكم الآلي.

الترميز

وألقيت العملات المعدنية ، والسيارات المارة ليست كذلكتشبه الأرقام 0 و 1. للإبلاغ عن الأحداث التي تحدث في المسافات ، تحتاج إلى التفكير في طريقة لوصف هذه الأحداث. هذا الوصف يسمى الترميز.

يمكن تشفير الرسائل بعدد لا نهائي من الطرق المختلفة. لكن شانون أظهر أن أقصر كود لا يمكن أن يكون أصغر من الإنتروبيا.

هذا هو السبب في أن إنتروبيا الرسالة هي مقياسالمعلومات في الرسالة. وبما أنه في جميع الحالات التي تم النظر فيها، فإن عدد البتات أثناء التشفير يساوي الإنتروبيا، وهذا يعني أن التشفير كان الأمثل. باختصار، لم يعد من الممكن تشفير الرسائل حول الأحداث في فضاءاتنا.

مع الترميز الأمثل، لا يمكنك أن تفقد أوتشويه بت واحد مرسل في الرسالة. وفي حالة فقدان ولو جزء واحد، سيتم تشويه المعلومات. لكن جميع قنوات الاتصال الحقيقية لا توفر الثقة بنسبة 100% في أن جميع أجزاء الرسالة ستصل إلى المستلم دون تشويه.

لإصلاح هذه المشكلة عليك القيام بهالكود ليس الأمثل، ولكنه زائد عن الحاجة. على سبيل المثال، أرسل مع الرسالة المجموع الاختباري الخاص بها - وهي قيمة محسوبة خصيصًا يتم الحصول عليها عند تحويل رمز الرسالة، والتي يمكن التحقق منها عن طريق إعادة الحساب عند استلام الرسالة. إذا كان المجموع الاختباري المرسل مطابقًا للمجموع المحسوب، فسيكون احتمال أن يكون الإرسال خاليًا من الأخطاء مرتفعًا جدًا. وإذا لم يتطابق المجموع الاختباري، فيجب طلب إعادة الإرسال. هذه هي الطريقة تقريبًا التي تعمل بها معظم قنوات الاتصال اليوم، على سبيل المثال، عند إرسال حزم المعلومات عبر الإنترنت.

رسائل اللغة الطبيعية

النظر في مساحة الحدث الذي يتكونمن المشاركات في اللغة الطبيعية. هذه حالة خاصة ، لكنها واحدة من أهمها. الأحداث هنا ستكون الأحرف المرسلة (أحرف الأبجدية الثابتة). تم العثور على هذه الأحرف في اللغة مع احتمالات مختلفة.

أكبر عدد من الترددات (أي رمز ذلكغالبًا ما توجد في جميع النصوص المكتوبة باللغة الروسية) مساحة: من ألف حرف ، يوجد متوسط مساحة 175 مرة. الثاني في التردد هو الرمز "o" - 90 ، متبوعًا بأحرف أخرى: "e" (أو "e" - لن نميزها) - 72 ، "a" - 62 ، و i - 62 ، وفقط أول حرف "t" - 53. والأندر "f" - يوجد هذا الرمز مرتين فقط لكل ألف حرف.

سوف نستخدم الحروف الروسية المكونة من 31 حرفًااللغة (لا تختلف عن "e" و "e" ، وكذلك "ъ" و "ь"). إذا تمت مصادفة جميع الأحرف في اللغة التي لها نفس الاحتمال ، فسيكون الانتروبيا لكل رمز H = 5 بت ، لكن إذا أخذنا في الاعتبار الترددات الحقيقية للرموز ، ستكون الإنتروبيا أقل: H = 4.35 بت. (هذا هو أقل مرتين تقريبًا من الترميز التقليدي ، عندما يتم إرسال حرف بايت 8 بايت).

لكن انتروبيا الشخصية في اللغة أقل. لا يتم تحديد احتمالية حدوث الحرف التالي تمامًا بواسطة متوسط تواتر الحرف في جميع النصوص. أي شخصية ستتبع تعتمد على الأحرف التي تم نقلها بالفعل. على سبيل المثال ، في اللغة الروسية الحديثة بعد الرمز "ъ" لا يمكن أن يتبع صوت الرمز ساكن. بعد حرفين متتاليين "e" ، يتبع حرف العلة الثالث "e" نادرًا جدًا ، إلا في كلمة "طويلة العنق". أي أن الشخصية التالية محددة إلى حد ما. إذا أخذنا في الاعتبار مثل هذا التحديد المسبق للرمز التالي ، فإن عدم اليقين (أي المعلومات) الخاصة بالرمز التالي سيكون أقل من 4.35. وفقًا لبعض التقديرات ، يتم تحديد الرمز التالي باللغة الروسية مسبقًا بواسطة بنية اللغة بأكثر من 50٪ ، أي أنه مع الترميز الأمثل ، يمكن نقل جميع المعلومات عن طريق حذف نصف الحروف من الرسالة.

شيء آخر هو أنه لا يمكن حذف كل حرف بأمان. على سبيل المثال ، من السهل تقاطع كلمة "o" عالية التردد (وعموما حروف العلة) ، ولكن نادرًا ما تكون "f" أو "e" إشكالية للغاية.

إن اللغة الطبيعية التي نتواصل بها مع بعضنا البعض زائدة عن الحاجة إلى حد كبير، وبالتالي يمكن الاعتماد عليها؛ وإذا أخطأنا في فهم شيء ما، فلا بأس، فسيتم نقل المعلومات.

لكن إلى أن قدمت Shannon مقياس المعلومات ، لم نتمكن من فهم أن اللغة لا لزوم لها ، وإلى أي مدى يمكننا ضغط الرسائل (ولماذا يتم ضغط الملفات النصية جيدًا بواسطة الأرشيف).

اللغة الطبيعية التكرار

في مقال "حول كيف نحن vorpsimanie tektkt"(الاسم يبدو هكذا تمامًا!) تم أخذ جزء من رواية نوبل نيست لإيفان تورجنيف وإخضاعه لبعض التحولات: تم حذف 34٪ من الرسائل من الجزء ، لكن ليس عشوائيًا. تم ترك الأحرف الأولى والأخيرة بالكلمات ، وتم حذف الحروف الساكنة فقط ، وليس الكل. لم يكن الهدف فقط من إتاحة الفرصة لاستعادة جميع المعلومات الموجودة على النص المحول ، ولكن أيضًا لضمان عدم مواجهة الشخص الذي قرأ هذا النص لأي صعوبات معينة بسبب الحروف المفقودة.

لماذا هو من السهل نسبيا قراءة هذا معطوبنص؟ فهو يحتوي في الواقع على المعلومات الضرورية لإعادة بناء الكلمات بأكملها. يمتلك المتحدث الأصلي باللغة الروسية مجموعة معينة من الأحداث (الكلمات والجمل بأكملها) التي يستخدمها للتعرف على الكلمات. بالإضافة إلى ذلك، يمتلك المتحدث أيضًا هياكل لغوية قياسية تحت تصرفه تساعده على استعادة المعلومات. على سبيل المثال،"إنها بلي بلي"- مع احتمال كبير يمكن قراءتها"لقد كانت أكثر حساسية.". ولكن تؤخذ بشكل منفصل"إنها أكثر بلاه"، بدلا من ذلك، سيتم استعادتها كما"كانت أكثر بياضا". منذ في الاتصالات اليومية نتعاملمع القنوات التي يوجد فيها ضوضاء وتداخل، نحن جيدون جدًا في استعادة المعلومات، ولكن فقط تلك التي نعرفها مسبقًا. على سبيل المثال العبارة"ميزاتها ليست في الأقل متعة ، htya nmngo rspkhli ورذاذ"يقرأ جيدًا باستثناء الكلمة الأخيرة"سبلاش" - "حشد". وهذه الكلمة غير موجودة في المعجم الحديث. عند قراءة كلمة بسرعة"Splls"يقرأ أكثر مثل "عالقون معًا"؛ عندما يكون بطيئًا، فإنه ببساطة يحير.

رقمنة الإشارة

الصوت ، أو التذبذبات الصوتية ، هو الجيوب الأنفية. يمكن ملاحظة ذلك ، على سبيل المثال ، على شاشة محرر الصوت. لنقل الصوت بدقة ، ستحتاج إلى عدد لا حصر له من القيم - موجة جيبية بأكملها. وهذا ممكن مع اتصال التناظرية. إنه يغني - تستمع ، لا تتم مقاطعة جهة الاتصال أثناء استمرار الأغنية.

في الاتصالات الرقمية عبر قناة ما، يمكننا فقط نقل عدد محدود من القيم. هل هذا يعني أنه لا يمكن إعادة إنتاج الصوت بدقة؟ اتضح لا.

الأصوات المختلفة هي موجة جيبية معدلة بشكل مختلف.ننقل فقط القيم المنفصلة (الترددات والسعات) ، ولا يلزم إرسال موجة الجيب نفسها - يمكن لجهاز الاستقبال توليدها.يولد الجيوب الأنفية، ويتم فرضه عليهالتشكيل الذي تم إنشاؤه من القيم المرسلة عبر قناة الاتصال. هناك مبادئ دقيقة يجب أن تنتقل بها القيم المنفصلة بحيث يتطابق الصوت عند الإدخال إلى قناة الاتصال مع الصوت عند الإخراج، حيث يتم تركيب هذه القيم على بعض الجيوب الأنفية القياسية (وهذا ما تقوله نظرية كوتيلنيكوف) عن).

نظرية كوتيلنيكوف (في أدب اللغة الإنجليزية - نظرية نيكويست - نظرية شانون ، نظرية القراءة)- بيان أساسي في المجال الرقميمعالجة الإشارات، وتوصيل الإشارات المستمرة والمنفصلة، والنص على أن "أي وظيفة F(t)، تتكون من ترددات من 0 إلى f1، يمكن إرسالها بشكل مستمر بأي دقة باستخدام أرقام تتبع بعضها البعض خلال 1/(2*f1) ثانية

مكافحة التدخل الترميز. رموز هامينج

إذا كان على قناة غير موثوقة للإرسالالنص المشفر لـ Ivan Turgenev ، وإن كان مع بعض الأخطاء ، سيؤدي إلى نص ذي معنى. ولكن إذا كنا بحاجة إلى نقل كل شيء إلى حد ما ، فستكون المهمة دون حل: لا نعرف البتات الخاطئة ، لأن الخطأ عشوائي. حتى المجموع الاختباري لا ينقذ دائمًا.

هذا هو السبب اليوم عند نقل البيانات علىلا تميل الشبكات كثيرًا إلى الترميز الأمثل ، حيث يمكن دفع الحد الأقصى من المعلومات في القناة ، ولكن إلى مثل هذا الترميز (لا لزوم له من الواضح) حيث يمكن استرداد الأخطاء - تمامًا مثلما نقرأ الكلمات في جزء إيفان تورغنيف.

هناك رموز خاصة لتصحيح الأخطاء تسمح لك باستعادة المعلومات بعد الفشل. واحد منهم هو رمز هامينغ.لنفترض أن لغتنا بأكملها تتكون من ثلاث كلمات:111000، 001110، 100011. يعرف كل من مصدر الرسالة والمتلقي هذه الكلمات. ونحن نعلم أن الأخطاء تحدث في قناة الاتصال، ولكن عند إرسال كلمة واحدة، لا يتم تشويه أكثر من بت واحد من المعلومات.

لنفترض أننا نجتاز كلمة 111000 أولاً. ونتيجة لذلك ، لا يوجد أكثر من خطأ واحد (حددنا الخطأ) يمكن أن يتحول إلى إحدى الكلمات:

1) 111000،011000 ، 101000 ، 110000 ، 111100 ، 111010 ، 111001.

عند نقل الكلمة 001110 ، قد تكون أي من الكلمات:

2) 001110،101110 ، 011110 ، 000110 ، 001010 ، 001100 ، 001111.

أخيرًا ، من أجل 100011 ، يمكننا الوصول إلى مكتب الاستقبال:

3) 100011،000011 ، 110011 ، 101011 ، 100111 ، 100001 ، 100010.

لاحظ أن القوائم الثلاث ليست ثنائية.تتقاطع. بمعنى آخر ، إذا ظهر في الطرف الآخر من قناة الاتصال أي كلمة من القائمة 1 ، فإن المستلم يعرف على وجه اليقين أن الكلمة 111000 قد نقلت إليه ، وإذا ظهرت أي كلمة من القائمة 2 ، الكلمة 001110 ، ومن القائمة 3 ، تظهر الكلمة 100011. يقولون أن كودنا إصلاح خطأ واحد.

حدث التصحيح بسبب عاملين.أولاً ، يعرف المستلم "القاموس" بأكمله، أي مساحة الحدث لمستلم الرسالة تتزامن مع مساحة الشخص الذي أرسل الرسالة. عندما تم إرسال الرمز مع وجود خطأ واحد فقط ، خرجت كلمة لم تكن موجودة في القاموس.

ثانياً ، تم اختيار الكلمات في القاموس بطريقة خاصة.وحتى لو حدث خطأ، فلن يتمكن المستلم من ذلكالخلط بين كلمة واحدة وأخرى. على سبيل المثال، إذا كان القاموس يتكون من كلمات "ابنة"، "نقطة"، "نتوء"، وأثناء الإرسال كانت النتيجة "فوشكا"، فإن المتلقي، وهو يعلم أن مثل هذه الكلمة غير موجودة، لن يتمكن من ذلك صحح الخطأ - قد يتبين أن أيًا من الكلمات الثلاث صحيحة. إذا كان القاموس يتضمن "نقطة" و"داو" و"فرع" ونعلم أنه لا يسمح بأكثر من خطأ واحد، فإن "فوشكا" هي بالتأكيد "نقطة" وليست "داو". في رموز تصحيح الأخطاء، يتم اختيار الكلمات بدقة بحيث يمكن "التعرف عليها" حتى بعد حدوث خطأ. والفرق الوحيد هو أن رمز "الأبجدية" يتكون من حرفين فقط - صفر وواحد.

التكرار لهذا الترميز كبير جدًا ، وعدد الكلمات التي يمكننا نقلها صغير جدًا.نحن بحاجة إلى استبعاد أي كلمة من القاموس،والتي، في حالة وجود خطأ، قد تتزامن مع القائمة بأكملها المقابلة للكلمات المرسلة (على سبيل المثال، لا يمكن أن تكون الكلمتان "ابنة" و "نقطة" في القاموس). لكن النقل الدقيق للرسائل مهم جدًا لدرجة أنه يتم بذل جهد كبير في البحث عن رموز مقاومة للأخطاء.

إحساس

مفاهيم الانتروبيا (أو عدم اليقين وعدم القدرة على التنبؤ) من الرسالة والتكرار (أو التحديد المسبق والقدرة على التنبؤ) بشكل طبيعي للغاية تتوافق مع أفكارنا بديهية حول قياس المعلومات. كلما كانت الرسالة غير قابلة للتنبؤ بها (كلما زاد الانتروبيا ، نظرًا لوجود احتمال أقل) ، زادت المعلومات التي تحملها. يعد الإحساس (على سبيل المثال ، الاجتماع مع تمساح على تفرسكايا) حدثًا نادرًا ، وقدرته على التنبؤ منخفضة جدًا ، وبالتالي فإن قيمة المعلومات مرتفعة. غالبًا ما تسمى المعلومات بالأخبار - تقارير عن الأحداث التي وقعت للتو ، والتي ما زلنا لا نعرف عنها شيئًا. لكن إذا أخبرونا بالمرتين الثانية والثالثة عن نفس الكلمات ، فسيكون التكرار رائعًا للرسالة ، وستتراجع درجة عدم القدرة على التنبؤ بها إلى الصفر ، ولن نستمع بعد ذلك إلى التلويح بعيدًا عن المتحدث بالكلمات "أعرف ، أعرف." لذلك ، تحاول وسائل الإعلام أن تكون الأولى. لعبت هذه المراسلات إلى الإحساس البديهي بالجدة ، والذي يؤدي إلى ظهور أخبار غير متوقعة حقًا ، دورًا رئيسيًا في حقيقة أن مقالة شانون ، التي لم تكن مخصصة للقارئ العام ، أصبحت ضجة كبيرة ، التقطتها الصحافة كمفتاح عالمي لمعرفة الطبيعة. - من اللغويين والنقاد الأدبيين إلى علماء الأحياء.

لكنشانون مفهوم المعلومات - نظرية رياضية صارمةوتطبيقها خارج نظرية الاتصالات غير موثوق بها للغاية. لكن في نظرية الاتصال نفسها ، تلعب دورا محوريا.

المعلومات الدلالية

شانون، يقدم مفهوم الإنتروبيا كمقياسالمعلومات، حصلت على الفرصة للعمل مع المعلومات - أولا وقبل كل شيء، قياسها وتقييم الخصائص مثل سعة القناة أو الترميز الأمثل. لكن الافتراض الرئيسي الذي سمح لشانون بالعمل بنجاح مع المعلومات كان الافتراض بأن توليد المعلومات هو عملية عشوائية يمكن وصفها بنجاح من حيث نظرية الاحتمالات.إذا كانت العملية غير عشوائية ، أي أنها تطيع القوانين (علاوة على ذلك ، فهي ليست واضحة دائمًا ، كما يحدث في اللغة الطبيعية) ، فإن منطق شانون لا ينطبق عليها.لا شيء يقوله شانون له علاقة بكون المعلومات ذات معنى.

بينما نتحدث عن الشخصيات (أو الحروف الأبجدية) ،يمكننا الجدال فيما يتعلق بالأحداث العشوائية ، ولكن حالما نتعرف على كلمات اللغة ، سيتغير الوضع بشكل كبير. الكلام عبارة عن عملية منظمة بشكل خاص ، وهنا لا تقل أهمية بنية الرسالة عن الأحرف التي يتم إرسالها بواسطتها.

في الآونة الأخيرة بدا الأمر وكأننا لا نستطيع فعل أي شيء.تم القيام به للاقتراب بطريقة أو بأخرى على الأقل من قياس معنى النص، ولكن في السنوات الأخيرة بدأ الوضع يتغير. ويرجع ذلك في المقام الأول إلى استخدام الشبكات العصبية الاصطناعية لمهام الترجمة الآلية والتلخيص التلقائي للنصوص واستخلاص المعلومات من النصوص وإنشاء التقارير باللغة الطبيعية. تتضمن كل هذه المهام تحويل وتشفير وفك تشفير المعلومات ذات المعنى الموجودة في اللغة الطبيعية. وتدريجيا تتشكل فكرة عن فقدان المعلومات خلال مثل هذه التحولات، وبالتالي عن مدى المعلومات ذات المعنى. لكن اليوم الوضوح والدقة التي تتمتع بها نظرية المعلومات لشانون ليست متوفرة بعد في هذه المشاكل الصعبة.