V klasickém experimentu psychologů Felixe Warnekena a Michaela Tomasella o lidském soc

Pak se stane něco úžasného:dítě nabízí pomoc. Poté, co dítě identifikovalo účel osoby, jde ke skříni a otevírá její dveře, což mu umožňuje vložit své knihy dovnitř. Ale jak může batole s tak omezenými životními zkušenostmi udělat takový závěr?

V poslední době počítačoví vědci přesměrovali tuto otázku na počítače: Jak mohou stroje dělat totéž?

Kritická součást k vytvořenítakové porozumění jsou chyby. Stejně jako batole může vyvodit cíl člověka pouze na základě jeho selhání, stroje, které určují cíle člověka, musí brát v úvahu naše chybné akce a plány.

Ve snaze znovu vytvořit tuto sociální inteligencive strojích vytvořili vědci z Laboratoře výpočetní techniky a umělé inteligence Massachusetts Institute of Technology (CSAIL) a Katedry mozkových a kognitivních věd algoritmus schopný identifikovat cíle a plány, i když by tyto plány mohly selhat.

Tento typ výzkumu může být nakonecpoužívá se k vylepšení řady asistenčních technologií, robotů pro spolupráci nebo úpravu a digitálních asistentů, jako jsou Siri a Alexa.

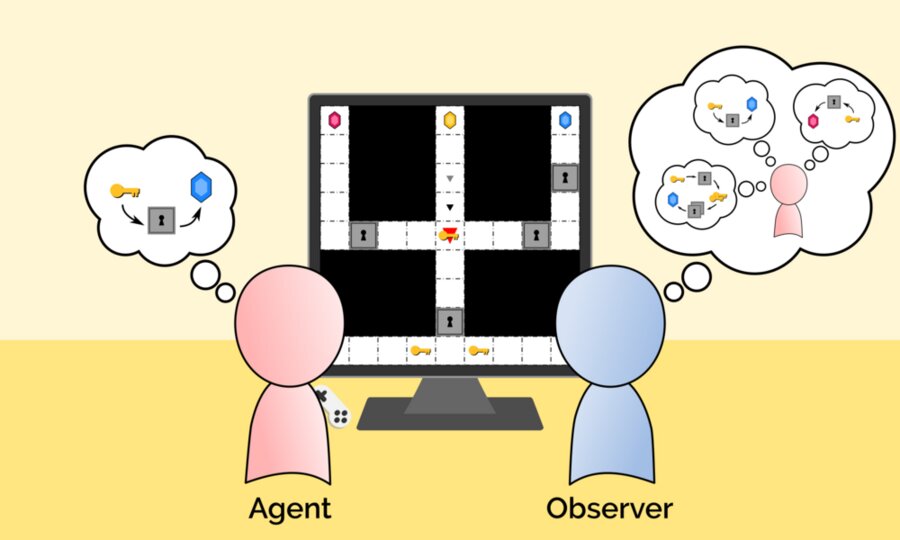

„Agent“ a „Observer“ ukazují, jak novéalgoritmus MIT je schopen určit cíle a plány, i když by tyto plány mohly selhat. Zde agent dělá chybný plán, jak dosáhnout modrého drahokamu, který pozorovatel považuje za možný. Uznání: Massachusetts Institute of Technology

„Agent“ a „Observer“ ukazují, jak novéalgoritmus MIT je schopen určit cíle a plány, i když by tyto plány mohly selhat. Zde agent dělá chybný plán, jak dosáhnout modrého drahokamu, který pozorovatel považuje za možný. Uznání: Massachusetts Institute of Technology

"Tato schopnost účtovat chyby může mít."rozhodující pro stavbu strojů, které spolehlivě vyvozují závěry a jednají naším jménem, vysvětluje Tang Chih-Xuan, Ph.D., student Massachusetts Institute of Technology (MIT) a hlavní autor nového výzkumného článku. „Jinak systémy AI mohou mylně dojít k závěru, že protože se nám nepodařilo dosáhnout našich cílů vyššího řádu, byly tyto cíle nakonec nežádoucí.“

K vytvoření jejich modelu použil týmGen, nová programovací platforma pro umělou inteligenci, která byla nedávno vyvinuta na MIT a kombinuje symbolické plánování umělé inteligence s Bayesianovým závěrem. Bayesiánská inference poskytuje optimální způsob, jak kombinovat nejisté víry s novými daty, a je široce používána pro hodnocení finančních rizik, diagnostické testování a předpovídání voleb.

Při vytváření algoritmu „Sekvenční vyhledáváníreverzní plán (SIPS) “vědci inspirovali obecný způsob plánování člověka, který je do značné míry neoptimální. Člověk nemusí plánovat všechno předem, ale spíše sestavit dílčí plány, realizovat je a na základě nových výsledků znovu vytvořit plány. I když to může vést k chybám v důsledku nedostatečného myšlení „předem“, tento typ myšlení snižuje kognitivní zátěž.

Vědci doufají, že jejich výzkum položí základynové filozofické a koncepční rámce potřebné k vytvoření strojů, které skutečně chápou lidské cíle, plány a hodnoty. Nový základní přístup modelování lidí jako nedokonalých myslitelů se inženýrům zdá velmi slibný.

Přečtěte si také

20 nových druhů zvířat a rostlin nalezených v Andách

Ve vesmíru jsou dálnice pro rychlé cestování. Jak se změní lety?

Pojmenována jako rostlina, která se nebojí změny klimatu. Živí miliardu lidí