Facebook wird Computer Vision und Systeme zur Verarbeitung natürlicher Sprache nutzen, die es bereits gibt

Der Roboter soll völlig autonom sein.und selbst lernen - systeme müssen direkt aus den rohdaten lernen. Auf diese Weise kann sich das Gerät nach Ansicht des Unternehmens schneller an neue Herausforderungen und veränderte Umstände anpassen. Die Grundlage der künstlichen Intelligenz wird das Lernen auf der Grundlage des RL-Modells sein, das es Robotern ermöglicht, durch Ausprobieren unabhängig zu lernen.

Wir möchten dem Roboter das Gehen ohne Hilfe beibringen. Bewegung ist eine sehr schwierige Aufgabe in der Robotik, und dies macht sie aus unserer Sicht sehr aufregend.

Facebook-Forschungsentwickler Roberto Calandra

Eine Besonderheit des Roboters von Facebookist, dass das Gerät keine Algorithmen für seine Bewegung implementiert werden. Zunächst kann er nicht schrittweise mit dem Lernalgorithmus gehen, sondern beginnt mit seinen Controllern zu interagieren, die bereits für die Bewegung aktiviert werden können. Je mehr Erfahrung ein Roboter hat, desto besser funktioniert er.

In diesem Fall muss der Roboter nicht nurBestimmen Sie Ihren Standort und Ihre Ausrichtung im Raum, halten Sie aber auch das Gleichgewicht und verbinden Sie die Impulse der Sensoren miteinander, um komplexe Mechanismen wie das Knie korrekt zu bedienen.

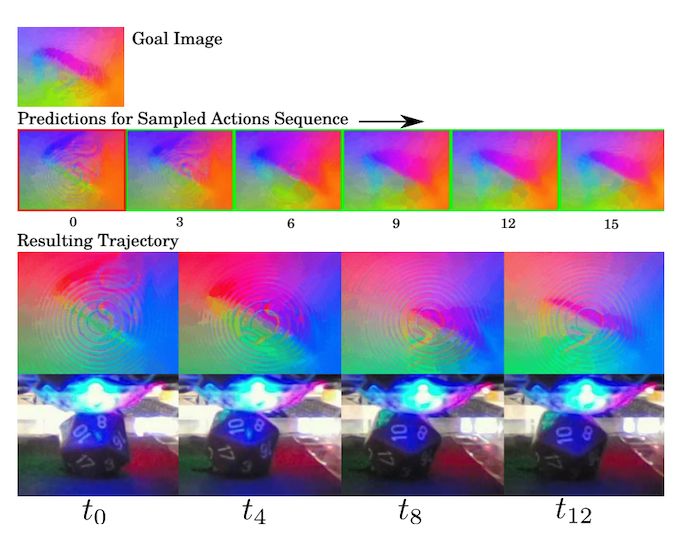

Roboter von Facebook für Computer VisionVerwenden Sie einen der Algorithmen, die entwickelt wurden, um die Popularität von Videos vorherzusagen. Ein neuronales Netzwerk kann mehrere Sekunden Video analysieren und weitere Frames vorhersagen, auch ohne es anzusehen, um die Analyse einer großen Menge an Material zu beschleunigen.

Im Rahmen des Facebook-Forschungsexperimentsführte das erste Gerät ein - einen Manipulator, der mit einem Joystick arbeiten, einen Würfel mit 20 Facetten rollen und die Ergebnisse, die in der einen oder anderen Sekunde fielen, richtig verstehen kann.

Die Kombination von visuellen und taktilen Informationsquellen kann laut Facebook die Lernmethoden und die Funktionalität zukünftiger selbstlernender Plattformen verbessern.

Nach Angaben der Entwickler nun ähnlichProjekte verwenden nur eine Art (maximal zwei) von Informationen, während Robotergeräte, damit sie vollständig funktionieren, Informationen mit unterschiedlichen Sinnen wahrnehmen müssen.