In un classico esperimento degli psicologi Felix Warneken e Michael Tomasello sull'uomo, il sociale

Poi accade qualcosa di incredibile:ragazzo offre aiuto. Individuato lo scopo della persona, il bambino va all'armadio e apre le sue porte, permettendo all'uomo di mettere i suoi libri all'interno. Ma come può un bambino con un'esperienza di vita così limitata trarre una tale conclusione?

Di recente, gli informatici hanno reindirizzato questa domanda ai computer: come possono le macchine fare lo stesso?

Una componente fondamentale da formaretale comprensione sono errori. Proprio come un bambino può dedurre l'obiettivo di una persona solo in base ai suoi fallimenti, le macchine che determinano gli obiettivi di una persona devono tenere conto delle nostre azioni e dei nostri piani errati.

Nel tentativo di ricreare questa intelligenza socialenelle macchine, i ricercatori del Computer Science and Artificial Intelligence Laboratory (CSAIL) del Massachusetts Institute of Technology e del Dipartimento di cervello e scienze cognitive hanno creato un algoritmo in grado di identificare obiettivi e piani, anche se tali piani potrebbero fallire.

Questo tipo di ricerca alla fine può essereutilizzato per migliorare una gamma di tecnologie assistive, robot di collaborazione o toelettatura e assistenti digitali come Siri e Alexa.

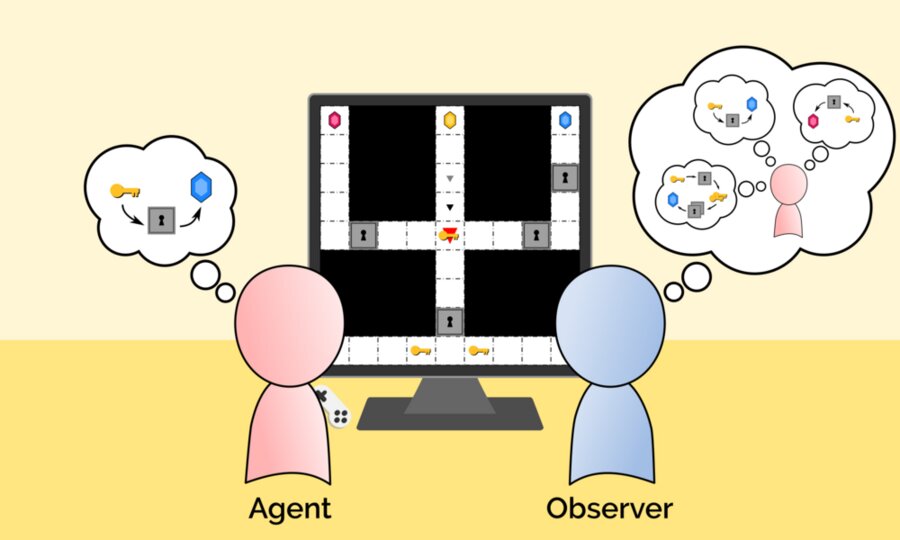

"Agent" e "Observer" dimostrano quanto siano nuovil'algoritmo del MIT è in grado di determinare obiettivi e piani anche se tali piani potrebbero fallire. Qui, l'agente fa un piano difettoso per raggiungere la gemma blu che l'osservatore considera possibile. Credito: Massachusetts Institute of Technology

"Agent" e "Observer" dimostrano quanto siano nuovil'algoritmo del MIT è in grado di determinare obiettivi e piani anche se tali piani potrebbero fallire. Qui, l'agente fa un piano difettoso per raggiungere la gemma blu che l'osservatore considera possibile. Credito: Massachusetts Institute of Technology

"Questa capacità di tenere conto degli errori può averefondamentale per la costruzione di macchine che traggono conclusioni affidabili e agiscono per nostro conto, spiega Tang Chih-Xuan, Ph.D., uno studente del Massachusetts Institute of Technology (MIT) e autore principale di un nuovo documento di ricerca. "Altrimenti, i sistemi di intelligenza artificiale potrebbero erroneamente concludere che, poiché non siamo riusciti a raggiungere i nostri obiettivi di ordine superiore, questi obiettivi erano in definitiva indesiderabili".

Per creare il loro modello, il team ha utilizzatoGen, una nuova piattaforma di programmazione AI recentemente sviluppata al MIT per combinare la pianificazione AI simbolica con l'inferenza bayesiana. L'inferenza bayesiana fornisce un modo ottimale per combinare convinzioni incerte con nuovi dati ed è ampiamente utilizzata per la valutazione del rischio finanziario, i test diagnostici e le previsioni elettorali.

Quando si crea l'algoritmo "Ricerca sequenzialeGli scienziati della Reverse Planning (SIPS) hanno ispirato un modo generale di pianificazione umana che è in gran parte subottimale. Una persona potrebbe non pianificare tutto in anticipo, ma piuttosto formare piani parziali, eseguirli e, sulla base di nuovi risultati, fare di nuovo piani. Sebbene possa portare a errori dovuti a un pensiero insufficiente "in anticipo", questo tipo di pensiero riduce il carico cognitivo.

Gli scienziati sperano che la loro ricerca getterà nuove basi filosofiche e concettuali necessarie per creare macchine che comprendano veramenteUn nuovo approccio di base per modellare gli esseri umani come pensatori imperfetti sembra molto promettente per gli ingegneri.

Leggi anche

20 nuove specie di animali e piante trovate nelle Ande

Ci sono autostrade nello spazio per i viaggi veloci. Come cambieranno i voli?

Nominato una pianta che non ha paura dei cambiamenti climatici. Nutre un miliardo di persone